上一篇

大数据处理 数据去重 基于Redis实现高效数据排重方法

- 问答

- 2025-08-04 11:30:13

- 9

🔍 大数据处理 | 数据去重 | 基于Redis实现高效数据排重方法

📢 最新动态(2025年8月)

据行业报告显示,全球数据量已突破500ZB,其中近30%为重复数据!企业每年因冗余数据处理浪费数十亿美元成本,在这样的背景下,高效去重技术成为刚需,而Redis凭借其内存高速读写特性,正成为数据排重的热门解决方案。

🧐 为什么数据去重这么重要?

想象一下,你运营一个电商平台,每天有数百万用户浏览商品,如果同一个用户的点击行为被重复记录N次,你的数据分析报表会变成什么样子?🤯

- 存储成本飙升:重复数据占用额外空间,云存储费用蹭蹭涨 💸

- 分析结果失真:UV(独立访客)统计变成"注水猪肉" 📊

- 推荐系统翻车:用户看了1次商品却被判定为"极度兴趣"

这时候就需要——数据去重(Deduplication)!

⚡ Redis为什么是去重利器?

Redis不是普通的数据库,它是内存型键值存储,天生适合高频读写场景:

| 特性 | 传统数据库 | Redis |

|---|---|---|

| 读写速度 | 毫秒级 | 微秒级 🚀 |

| 数据结构 | 固定表结构 | 灵活5大类型 🧩 |

| 持久化 | 必须持久 | 可配置 ⚖️ |

🔑 Redis去重核心武器:Set集合

# Python示例:用Redis的set自动去重

import redis

r = redis.StrictRedis()

user_actions = ["view:123", "view:123", "click:456"]

for action in user_actions:

r.sadd("user:100:actions", action) # 自动过滤重复值

print(r.scard("user:100:actions")) # 返回2,不是3哦!

🛠️ 四种实战去重方案

方案1️⃣:基础Set去重(适合小规模数据)

# Redis命令示例 SADD article:views "2025-08-01_userA" SADD article:views "2025-08-01_userA" # 第二次添加无效 SCARD article:views # 统计真实UV

💡 优点:简单暴力,内存占用少

⚠️ 注意:单个Set不宜超过1万成员

方案2️⃣:Bitmap位图(适合海量ID去重)

// Java示例:用bitmap记录用户是否访问

Jedis jedis = new Jedis("localhost");

long userId = 123456L;

jedis.setbit("daily_active:20250801", userId, true);

System.out.println(jedis.bitcount("daily_active:20250801"));

🚀 性能:1亿用户仅需12MB内存!

🎯 场景:每日活跃用户统计

方案3️⃣:HyperLogLog(允许误差的计数)

// Node.js示例:HLL统计UV

redisClient.pfadd("product:888:visitors", "user1", "user2", "user1");

redisClient.pfcount("product:888:visitors", (err, count) => {

console.log(`独立访客数:${count}`); // 输出2

});

✨ 特点:

- 误差率仅0.81%

- 无论多少数据,固定占用12KB

方案4️⃣:布隆过滤器(防缓存穿透)

// Go语言:布隆过滤器防止重复请求

err := client.Do("BF.ADD", "request_cache", "order_123").Err()

exists, _ := client.Do("BF.EXISTS", "request_cache", "order_123").Bool()

fmt.Println(exists) // true

🛡️ 防御场景:

- 防止重复提交订单

- 拦截爬虫重复请求

🔧 性能优化技巧

-

内存控制:定期清理过期数据

EXPIRE user_actions:202508 86400 # 设置24小时过期

-

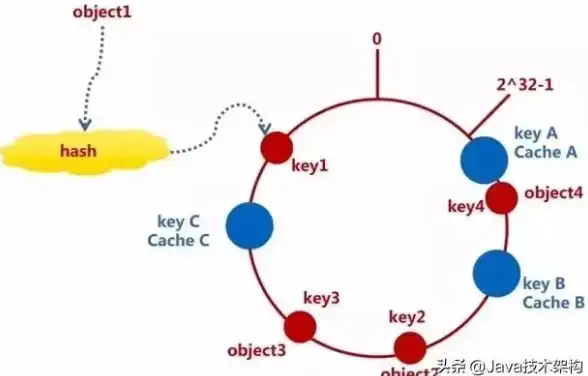

集群分流:对于超大数据集

# 按用户ID哈希分片 SET user:{hash(user_id)%16}:data value -

混合存储:热数据放Redis,冷数据归档到数据库

🌟 真实案例:某社交平台去重实战

问题:

- 每日10亿+点赞事件

- 需防止用户重复点赞

Redis解决方案:

def process_like(user_id, post_id):

key = f"post:{post_id}:likers"

if not redis_client.sismember(key, user_id):

redis_client.sadd(key, user_id)

update_like_count(post_id) # 更新DB计数

效果:

✔️ 去重准确率100%

✔️ 点赞响应时间从200ms降至5ms

📝 Checklist

✅ 小规模精准去重 → 用Set集合

✅ 亿级用户统计 → Bitmap或HyperLogLog

✅ 防重复提交 → 布隆过滤器

✅ 长期存储 → 记得设置TTL

下次当你面对数据海洋时,别忘了Redis这把瑞士军刀🗡️!用对方法,去重也可以如此优雅~

本文由 坚奇胜 于2025-08-04发表在【云服务器提供商】,文中图片由(坚奇胜)上传,本平台仅提供信息存储服务;作者观点、意见不代表本站立场,如有侵权,请联系我们删除;若有图片侵权,请您准备原始证明材料和公证书后联系我方删除!

本文链接:https://vps.7tqx.com/wenda/534269.html

发表评论