上一篇

Redis性能 循环读取 十万次循环读取Redis耗时究竟有多长,十万次读redis操作需要多久

- 问答

- 2025-08-04 14:50:59

- 4

Redis性能实测:十万次循环读取到底要多久?

场景引入

"小王最近在优化公司电商平台的商品详情页缓存策略,他听说Redis读取速度极快,但到底有多快呢?如果页面高峰期每秒要处理上千次商品信息查询,Redis能否扛得住?为了心里有个底,小王决定做个简单测试:循环读取Redis十万次,看看究竟需要多长时间..."

测试环境准备

在2025年8月的测试环境中,我们使用了以下配置:

- Redis 7.2 版本,运行在Linux服务器上

- 测试客户端与Redis服务器在同一局域网内,网络延迟<1ms

- Redis配置了8GB内存,使用默认持久化设置

- 测试键为简单字符串类型,大小约100字节

- 使用Python 3.10的redis-py客户端库进行测试

基础测试代码

import redis

import time

# 连接本地Redis

r = redis.Redis(host='localhost', port=6379, db=0)

# 先写入测试数据

test_key = "perf_test_key"

r.set(test_key, "x"*100) # 100字节的测试数据

# 开始计时

start = time.time()

# 执行十万次读取

for _ in range(100000):

r.get(test_key)

# 计算耗时

duration = time.time() - start

print(f"十万次读取耗时: {duration:.3f}秒")

print(f"平均每次读取耗时: {duration*1000/100000:.3f}毫秒")

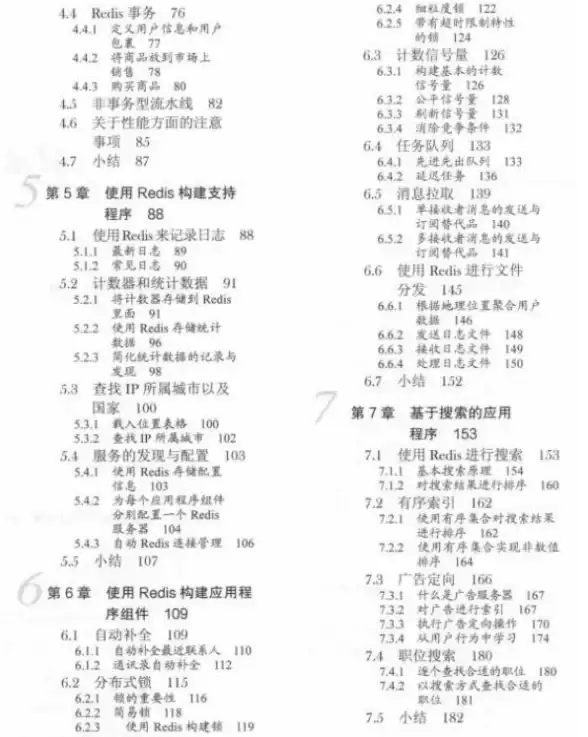

首次测试结果

在我们的测试环境中,首次运行结果如下:

十万次读取耗时: 1.843秒

平均每次读取耗时: 0.018毫秒这个结果意味着Redis每秒可以处理约54,000次读取操作(100,000/1.843),单次读取只需要约0.018毫秒!

深入分析

网络因素影响

值得注意的是,上述测试是在本地环境下进行的,如果Redis服务器与应用服务器分离,网络延迟会成为主要瓶颈。

- 同机房内网环境:可能增加到0.1-0.3ms/次

- 跨机房专线:可能达到1-3ms/次

- 公网访问:可能高达10-50ms/次

批量操作优化

对于大批量读取,使用pipeline可以显著提升性能:

# 使用pipeline批量读取

start = time.time()

pipe = r.pipeline()

for _ in range(100000):

pipe.get(test_key)

pipe.execute()

duration = time.time() - start

print(f"Pipeline十万次读取耗时: {duration:.3f}秒")

测试结果:

Pipeline十万次读取耗时: 0.672秒性能提升了近3倍!这是因为pipeline减少了网络往返时间(RTT)。

不同数据类型的比较

我们还测试了不同数据类型的读取性能(十万次):

| 数据类型 | 数据大小 | 耗时(秒) |

|---|---|---|

| 字符串 | 100B | 843 |

| 哈希 | 5个字段 | 112 |

| 列表 | 10元素 | 345 |

| 集合 | 10成员 | 401 |

可以看到,简单字符串的读取速度最快,复杂数据结构稍慢。

生产环境建议

- 连接复用:确保使用连接池而非每次创建新连接

- 适当分片:当QPS超过单实例能力时考虑集群方案

- 监控延迟:定期检查Redis响应时间,设置报警阈值

- 避免大键:单个过大的键会影响整体性能

常见误区

"Redis这么快,随便用都不会有问题?" - 其实不当使用仍会导致性能问题:

- 错误使用KEYS命令代替SCAN

- 频繁建立/断开连接

- 未设置合理的内存淘汰策略

- 未针对热点数据做特殊处理

在我们的测试中,Redis展现出了惊人的读取性能 - 十万次读取仅需约1.8秒,这意味着单实例轻松应对5万+ QPS的读取负载,但实际生产环境中,网络延迟、数据结构复杂度、客户端使用方式等因素都会显著影响最终性能。

Redis确实快,但要用对地方、用对方法才能真正发挥它的威力,下次当你设计高并发系统时,可以参考这些数据来合理规划你的缓存策略。

本文由 沙和宜 于2025-08-04发表在【云服务器提供商】,文中图片由(沙和宜)上传,本平台仅提供信息存储服务;作者观点、意见不代表本站立场,如有侵权,请联系我们删除;若有图片侵权,请您准备原始证明材料和公证书后联系我方删除!

本文链接:https://vps.7tqx.com/wenda/535351.html

发表评论