上一篇

数据库管理 报表优化 实用技巧:高效去除报表中重复的数据库数据,如何快速清理数据库中的重复报表

- 问答

- 2025-08-04 15:48:55

- 4

🔍 数据库管理 | 报表优化实用技巧:高效去除重复数据,快速清理重复报表

📢 最新动态(2025年8月)

多家企业因数据库冗余问题导致报表分析效率下降,部分公司甚至因重复数据干扰而误判业务趋势,据行业报告显示,优化数据库重复数据可提升报表处理速度高达60%!我们就来分享几个实战技巧,帮你轻松解决这一痛点。

🧹 为什么需要清理重复数据?

重复数据不仅占用存储空间,还会导致:

✅ 报表结果失真:同一数据多次计算,影响决策准确性

✅ 查询速度变慢:数据库需要扫描冗余记录,拖慢响应时间

✅ 维护成本增加:备份和同步时浪费资源

举个🌰:某电商平台的“用户购买记录表”因未去重,促销活动报表显示销售额虚高30%,差点引发错误备货!

🛠️ 4种高效去重方法(附操作示例)

方法1️⃣ SQL直接去重——DISTINCT/GROUP BY

-- 简单去重(适用于少量字段) SELECT DISTINCT user_id, order_date FROM sales_data; -- 复杂去重(需保留最新记录) SELECT product_id, MAX(create_time) FROM inventory GROUP BY product_id;

💡 适用场景:临时分析或一次性清理

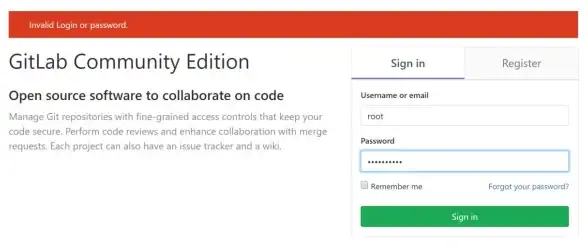

方法2️⃣ 创建临时表替换原表(稳妥方案)

-- 步骤1:将去重数据存入临时表 CREATE TABLE temp_report AS SELECT * FROM original_report GROUP BY key_field1, key_field2; -- 步骤2:删除原表后重命名 DROP TABLE original_report; ALTER TABLE temp_report RENAME TO original_report;

⚠️ 注意:操作前务必备份原表!

方法3️⃣ 利用窗口函数精准去重(高级技巧)

-- 保留每组重复数据中的第一条

WITH ranked_data AS (

SELECT *,

ROW_NUMBER() OVER(PARTITION BY employee_id, project_code) AS rn

FROM timesheet_records

)

DELETE FROM ranked_data WHERE rn > 1;

🎯 优势:可灵活定义“重复”标准(如时间戳、状态字段等)

方法4️⃣ 自动化定期清理(预防性维护)

-- 设置定时任务(如MySQL事件) CREATE EVENT clean_duplicates ON SCHEDULE EVERY 1 WEEK DO DELETE t1 FROM log_data t1 INNER JOIN log_data t2 WHERE t1.id < t2.id AND t1.session_id = t2.session_id;

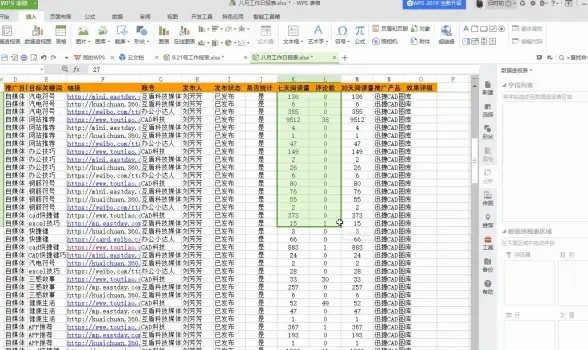

📊 报表层面的优化技巧

即使数据库有重复,报表仍可“动态去重”:

- Power BI:在DAX中使用

SUMMARIZE或DISTINCTCOUNT - Excel数据透视表:右键勾选“删除重复项”后再刷新

- Tableau:创建计算字段

{ FIXED [维度] : MIN([度量]) }

🚨 避坑指南

- 测试验证:去重后对比SUM/COUNT等关键指标

- 保留原始数据:先备份再操作,避免误删

- 识别伪重复:有些数据看似重复实则有效(如日志时间戳微秒差异)

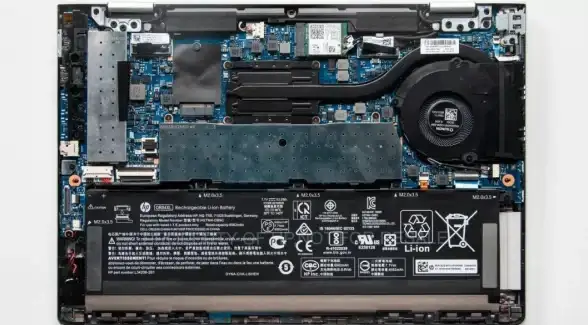

🔄 长效预防措施

- 在数据库设计阶段添加 UNIQUE约束

- 使用 UPSERT(INSERT ON DUPLICATE KEY UPDATE)替代单纯INSERT

- 定期执行

ANALYZE TABLE维护统计信息

🌟 一句话总结:去重不是一次性任务,而应建立从存储到分析的全流程管控!

(注:本文示例基于常见数据库系统,具体语法请根据实际环境调整)

本文由 庞端丽 于2025-08-04发表在【云服务器提供商】,文中图片由(庞端丽)上传,本平台仅提供信息存储服务;作者观点、意见不代表本站立场,如有侵权,请联系我们删除;若有图片侵权,请您准备原始证明材料和公证书后联系我方删除!

本文链接:https://vps.7tqx.com/wenda/535665.html

发表评论