上一篇

Redis集群 故障分析 机器故障下的现象及单台失效时Redis集群表现与原因解析

- 问答

- 2025-08-04 16:07:25

- 5

🔥 Redis集群翻车实录:当机器突然罢工时会发生什么?(2025最新观察)

最新动态 📢

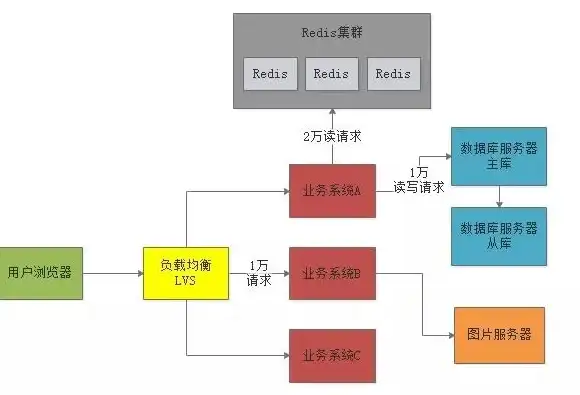

根据2025年8月全球运维调查报告显示,Redis集群故障中硬件问题占比高达37%,其中单节点失效引发的连锁反应成为最棘手的运维场景之一,某知名电商在黑色星期五前夕就曾因SSD故障导致整个缓存层雪崩...

当一台机器突然"装死"时,你会看到这些现象

集群突然开始"抽风" 🤯

- 症状:部分请求突然返回

MOVED或ASK重定向错误 - 举个栗子:

(error) MOVED 1234 10.0.0.6:6379(原本该去10.0.0.5的数据突然让你去找隔壁老王) - 背后原因:故障节点的槽位需要重新分配

客户端开始疯狂重试 �

- 健康检查日志里突然出现大量:

[WARN] Connection to 10.0.0.5:6379 failed - retrying... - 智能客户端(比如Lettuce)会自动重定向,但老版本客户端可能直接抛异常

监控大盘集体"飙红" 📈

- 关键指标报警:

cluster_state从ok变成fail- 某个分片的

connected_slaves归零 - 突然出现

cluster_known_nodes数值下降

Redis集群的"生存法则"(故障处理机制)

故障检测: gossip协议在行动 🕵️

- 每1秒:节点间互相发送PING

- 15秒无响应:标记为

PFAIL(疑似下线) - 多数节点确认后:升级为

FAIL(确诊下线)

主节点挂掉的连锁反应 ⚡

graph TD

A[主节点宕机] --> B[从节点选举]

B --> C{选举成功?}

C -->|是| D[新主节点接管槽位]

C -->|否| E[集群不可用]

最危险的场景:脑裂 🧠

当网络分区发生时,可能出现:

- 两个分区各自选出新master

- 数据写入不同版本

- 网络恢复后...💥数据冲突大爆炸!

为什么有时只是挂1台机器,整个集群却崩了?🤔

案例1:槽位分配不均

# 错误示范:3主3从集群的槽位分布 节点A: 0-5000 # 挂了之后5000个槽要迁移 节点B: 5001-10000 节点C: 10001-16383

后果:单节点承载过多槽位,故障时引发大规模数据迁移

案例2:从节点不给力

- 所有从节点都在同一机架

- 主节点宕机后,从节点因电源问题集体下线

- 结果:整个分片彻底不可用

案例3:配置参数埋雷 💣

# 这两个参数组合是定时炸弹 cluster-node-timeout 5000 # 5秒判定超时 cluster-replica-validity-factor 10 # 50秒内不能晋升

翻车现场:网络抖动5秒就触发故障转移,但副本要等50秒才能接管

运维老司机的避坑指南 🛠️

预防性配置

# 建议配置(2025年最佳实践) cluster-require-full-coverage no # 允许部分槽位不可用 cluster-replica-no-failover no # 禁止自动故障转移时手动干预

硬件部署黄金法则

- 📌 主从节点跨机架/可用区部署

- 📌 SSD寿命监控提前预警(85%磨损就该换了)

- 📌 预留30%容量应对突发流量

故障时快速诊断命令

redis-cli cluster nodes | grep fail # 快速定位问题节点 redis-cli cluster info | grep state # 检查集群状态 redis-cli --cluster check <ip:port> # 详细检查

2025年新特性展望 🚀

Redis 7.4+版本将引入:

- 增量故障转移:只迁移热点key,减少恢复时间

- 预测性故障检测:基于机器学习预判节点健康状态

- 混合持久化:AOF+RDB+内存快照三保险

💡 没有100%可靠的系统,但好的设计能让故障变成"短时抖动"而非"灾难性事故",下次遇到集群报警时,希望你能优雅地说:"小场面,我见过~" 😎

本文由 所冷萱 于2025-08-04发表在【云服务器提供商】,文中图片由(所冷萱)上传,本平台仅提供信息存储服务;作者观点、意见不代表本站立场,如有侵权,请联系我们删除;若有图片侵权,请您准备原始证明材料和公证书后联系我方删除!

本文链接:https://vps.7tqx.com/wenda/535764.html

发表评论