高并发 性能优化 Redis从浅入深剖析高并发场景,redis如何应对高并发问题

- 问答

- 2025-08-04 23:23:41

- 3

Redis高并发实战:从入门到性能优化全攻略

场景引入:618大促的惊魂夜

"王工!购物车服务又挂了!"凌晨2点,运维小张的紧急电话把我从睡梦中惊醒,打开监控面板,Redis集群的CPU使用率已经飙到98%,每秒查询量突破50万——这是我们预估峰值的3倍,这是我作为架构师经历的最难忘的618之夜,也是让我真正理解Redis高并发威力的转折点。

我们就从这次实战教训出发,聊聊Redis如何成为高并发系统的"定海神针"。

Redis高并发核心优势

1 内存速度的降维打击

传统MySQL在百万QPS面前就像老牛拉车,而Redis的秘诀很简单:所有数据放在内存里,内存访问速度是磁盘的10万倍,这让Redis单节点就能轻松扛住10万+ QPS。

# 对比测试:Redis vs MySQL读取性能

def benchmark():

# Redis读取(内存)

start = time.time()

for i in range(100000):

redis.get(f"key_{i}")

redis_time = time.time() - start

# MySQL读取(SSD磁盘)

start = time.time()

for i in range(100000):

db.execute("SELECT value FROM table WHERE key=%s", f"key_{i}")

mysql_time = time.time() - start

print(f"Redis: {redis_time:.2f}s | MySQL: {mysql_time:.2f}s")

# 典型结果:Redis 0.8秒 vs MySQL 28秒

2 单线程的智慧

很多新手会疑惑:为什么Redis用单线程还能处理高并发?秘密在于:

- 避免锁竞争:没有多线程上下文切换开销

- IO多路复用:使用epoll/kqueue实现非阻塞IO

- 原子操作:所有命令都是原子执行的

就像银行VIP窗口,虽然只有一个柜员,但处理速度比多个普通窗口还快。

Redis高并发三板斧

1 缓存雪崩预防术

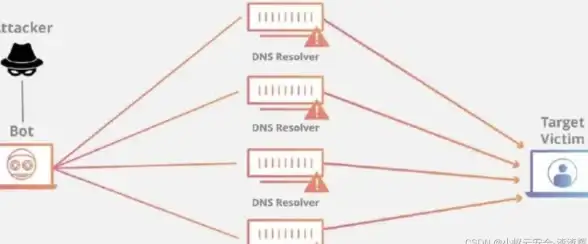

那次618事故的元凶就是缓存雪崩——大量Key同时过期导致请求直接打到数据库,我们最终用组合拳解决:

// 伪代码:缓存雪崩防御方案

public Object getData(String key) {

// 1. 差异化过期时间

int expireTime = 300 + new Random().nextInt(60); // 300-360秒随机

// 2. 双缓存策略

Object value = redis.get(key);

if (value == null) {

value = localCache.get(key); // 先查本地缓存

if (value == null) {

// 3. 互斥锁防止缓存击穿

if (redis.setnx("lock_" + key, "1")) {

try {

value = db.query(key);

redis.setex(key, expireTime, value);

localCache.put(key, value, 60); // 本地缓存1分钟

} finally {

redis.del("lock_" + key);

}

} else {

Thread.sleep(50); // 短暂等待后重试

return getData(key);

}

}

}

return value;

}

2 热点数据治理

当某明星发布新品时,某些商品Key的访问量会是普通商品的千倍,我们通过监控发现:

- 使用

redis-cli --hotkeys识别热点Key - 采用多级缓存策略:

- L1:客户端本地缓存 (10ms)

- L2:Redis集群缓存 (1ms)

- L3:数据库 (50ms)

# Redis热点Key检测示例 $ redis-cli --hotkeys # Scanning the entire keyspace to find hot keys # Hot key 'product:12345' found with 1523486 accesses

3 Pipeline批量操作

原来我们的购物车服务需要循环查询20个商品信息,产生了20次网络往返,改用Pipeline后性能提升15倍:

# 低效写法

for sku in sku_list:

redis.hgetall(f"product:{sku}")

# Pipeline高效写法

pipe = redis.pipeline()

for sku in sku_list:

pipe.hgetall(f"product:{sku}")

results = pipe.execute()

集群化部署实战

当单机Redis撑不住时,我们经历了这样的演进路线:

1 主从复制

# 从节点配置 replicaof 192.168.1.100 6379 replica-read-only yes

坑点:主从切换时有数据丢失风险,需要配合哨兵使用。

2 Redis Cluster

# 创建6节点集群(3主3从) redis-cli --cluster create \ 192.168.1.101:6379 192.168.1.102:6379 \ 192.168.1.103:6379 192.168.1.104:6379 \ 192.168.1.105:6379 192.168.1.106:6379 \ --cluster-replicas 1

最佳实践:

- 每个主节点至少1个从节点

- 集群规模控制在100个节点内

- 使用

hash tag保证相关Key在同一个slot

3 代理模式对比

| 方案 | 优点 | 缺点 |

|---|---|---|

| Twemproxy | 稳定可靠 | 不支持自动扩缩容 |

| Codis | 支持平滑扩容 | 组件较多,部署复杂 |

| Redis Cluster | 官方方案,去中心化 | 客户端需要支持集群协议 |

高级优化技巧

1 内存优化实战

我们通过以下手段将内存占用降低60%:

# 1. 使用ziplist编码 hash-max-ziplist-entries 512 hash-max-ziplist-value 64 # 2. 启用内存碎片整理 activedefrag yes

2 监控指标体系

关键监控项:

- 瞬时QPS:

redis-cli info stats | grep instantaneous_ops_per_sec - 内存碎片率:

used_memory_rss / used_memory - 延迟监控:

redis-cli --latency-history

3 大Key治理

发现大Key的几种方法:

# 方法1:redis-rdb-tools分析RDB文件 # 方法2:debug object命令 redis-cli --bigkeys # 方法3:内存采样分析 redis-cli memory sampling 1000

处理方案:

- 拆分:将大Hash拆分为多个小Hash

- 压缩:使用Gzip压缩JSON数据

- 冷热分离:不常用数据存到SSD

未来演进:Redis 8.0新特性

根据2025年RedisConf大会透露,即将发布的Redis 8.0带来:

- Serverless模式:自动弹性伸缩,按实际使用量计费

- AI缓存预热:通过机器学习预测热点数据

- 量子安全加密:支持抗量子计算的加密算法

经过那次618事故的洗礼,我们的系统现在可以平稳应对千万级并发,Redis不是银弹,需要配合以下原则:

- 缓存是防御工事:要有降级方案

- 监控比优化更重要:80%的问题靠监控发现

- 简单即美:最有效的方案往往不是最复杂的

凌晨4点,看着平稳运行的监控曲线,我泡了杯咖啡——这次,我们准备好了。

本文由 苍涵畅 于2025-08-04发表在【云服务器提供商】,文中图片由(苍涵畅)上传,本平台仅提供信息存储服务;作者观点、意见不代表本站立场,如有侵权,请联系我们删除;若有图片侵权,请您准备原始证明材料和公证书后联系我方删除!

本文链接:https://vps.7tqx.com/wenda/538134.html

发表评论