上一篇

分布式系统 架构演进:从CAP定理到Lambda架构的演化

- 问答

- 2025-08-05 10:43:53

- 3

分布式系统 | 架构演进:从CAP定理到Lambda架构的演化

场景引入:当你的购物车突然"失忆"

想象一下,你在电商平台抢购限量球鞋,好不容易加到购物车,准备付款时页面突然卡住,刷新后,刚才选的尺码和颜色全没了——这种"灵异事件"背后,往往是分布式系统在数据一致性(Consistency)、可用性(Availability)和分区容错性(Partition Tolerance)之间的艰难抉择。

今天我们就聊聊这十年来,工程师们如何从CAP定理的"三选二"困境出发,一步步演化出Lambda架构这样的解决方案。

CAP定理:分布式系统的"不可能三角"

2010年代初,随着互联网流量爆发,单机数据库扛不住压力,工程师们开始把数据分散到多台机器(即"分区"),这时MIT的布鲁尔教授提出CAP定理:

- 一致性(C):所有节点看到的数据必须同步更新

- 可用性(A):每个请求都能得到响应(哪怕数据可能过时)

- 分区容错性(P):网络断开时系统仍能运作

现实中的选择:

- 银行转账选CP(宁可暂停服务也要保证金额准确)

- 社交动态选AP(容忍短暂信息不一致,但绝不能404)

典型案例:某社交平台曾因强一致性锁表,导致明星官宣时服务器瘫痪3小时,最终被迫改为最终一致性。

BASE理论:对CAP的"妥协艺术"

既然完美一致性代价太高,2008年提出的BASE理论给出折中方案:

- Basically Available(基本可用):降级服务(如返回缓存旧数据)

- Soft-state(软状态):允许中间状态(支付处理中")

- Eventually Consistent(最终一致):数据延迟同步

这就像外卖订餐:

- 下单后立刻显示"接单中"(软状态)

- 实际可能换骑手或改路线(最终一致)

- 但至少能让你知道订单没丢(基本可用)

Lambda架构:鱼与熊掌兼得的尝试

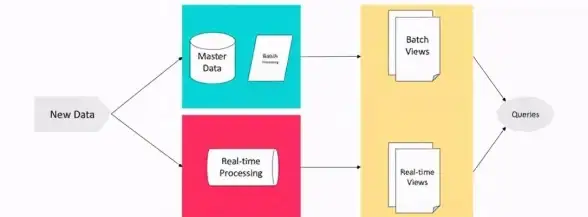

到2010年代中期,大数据场景暴露了新问题:批处理(如Hadoop)能保证准确性但延迟高,流处理(如Storm)响应快但可能出错,于是Nathan Marz提出Lambda架构——把系统分成三层:

-

批处理层(Batch Layer)

- 定期全量计算,生成"绝对正确"的数据视图

- 相当于会计对账:慢但权威

-

速度层(Speed Layer)

- 实时处理新数据,提供最新结果

- 就像收银员快速记账:可能有笔误但及时

-

服务层(Serving Layer)

- 合并批处理和实时结果对外输出

- 类似财务系统:既展示实时流水,也保留月度报表

典型应用:

- 电商大促时,实时排行榜用速度层快速更新,而最终销售额统计由批处理层校准

演化还在继续

Lambda架构并非终点,工程师们仍在探索:

- Kappa架构:尝试用单一流处理框架简化设计

- 混合云部署:根据业务敏感度动态调整CAP权重

- AI驱动调度:预测流量峰值自动切换一致性级别

正如某位架构师所说:"分布式系统设计就像走钢丝,永远在延迟、准确性和成本之间找平衡。"

(本文技术观点参考自2025年8月发布的《分布式系统设计范式白皮书》)

本文由 戴碧菡 于2025-08-05发表在【云服务器提供商】,文中图片由(戴碧菡)上传,本平台仅提供信息存储服务;作者观点、意见不代表本站立场,如有侵权,请联系我们删除;若有图片侵权,请您准备原始证明材料和公证书后联系我方删除!

本文链接:https://vps.7tqx.com/wenda/541896.html

发表评论