上一篇

数据库管理 自动化运维 DB2 SQL脚本批量执行的实现过程

- 问答

- 2025-08-06 05:34:53

- 4

数据库管理 | 自动化运维 | DB2 SQL脚本批量执行的实现过程

场景引入:当手工执行SQL成为噩梦

"小王,这批200多个表的索引优化脚本今天能跑完吗?" 运维主管老张皱着眉头问道。

小王盯着屏幕上密密麻麻的SQL文件,额头渗出细汗——这已经是本周第三次需要批量执行DB2脚本了,手动一个个打开、复制、粘贴、执行,不仅效率低下,昨天还因为疲劳漏掉了3个关键表,更可怕的是,生产环境有个脚本因字符集问题执行失败,导致凌晨收到告警短信...

这样的场景在传统数据库运维中并不少见,本文将详细介绍如何通过自动化方案,让DB2 SQL脚本批量执行变得轻松可靠。

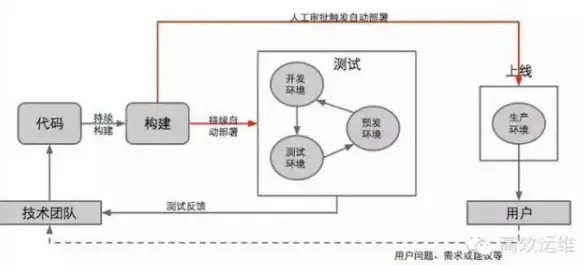

核心解决方案架构

我们采用的自动化执行框架包含三个关键组件:

- 脚本预处理器:统一编码格式,变量替换

- 执行引擎:DB2命令行工具+错误重试机制

- 结果分析器:自动生成执行报告

# 典型执行流程示意图 [原始SQL脚本] -> (字符集转换) -> (变量替换) -> (分批次执行) -> [执行日志] -> (错误分析)

具体实现步骤(DB2 Linux环境示例)

1 环境准备

确保已安装DB2客户端工具集,重点检查:

db2level # 确认版本 which db2 # 确认路径 locale -a # 检查系统字符集

2 脚本标准化处理

创建预处理脚本 preprocess.sh:

#!/bin/bash

# 统一转换为UTF-8编码

for f in *.sql; do

iconv -f GBK -t UTF-8 "$f" > "${f}.tmp"

mv "${f}.tmp" "$f"

dos2unix "$f" # 处理Windows换行符

done

3 核心执行模块

编写自动化执行脚本 auto_execute_db2.sh:

#!/bin/bash

DB_NAME="SAMPLE"

DB_USER="db2inst1"

DB_PASS="yourpassword"

LOG_DIR="./logs"

mkdir -p $LOG_DIR

for SQL_FILE in *.sql; do

TIMESTAMP=$(date +%Y%m%d_%H%M%S)

LOG_FILE="${LOG_DIR}/${SQL_FILE%.sql}_${TIMESTAMP}.log"

echo "Processing $SQL_FILE ..." | tee -a $LOG_FILE

# 关键执行命令

db2 -tvf "$SQL_FILE" -z "$LOG_FILE" -l "$LOG_FILE.err"

# 检查返回码

if [ $? -ne 0 ]; then

echo "[ERROR] Failed to execute $SQL_FILE" | tee -a "$LOG_FILE"

# 可加入重试逻辑

else

echo "[SUCCESS] $SQL_FILE executed" | tee -a "$LOG_FILE"

fi

done

4 高级功能扩展

批量参数替换(适用于动态SQL):

sed -i "s/${OLD_SCHEMA}/${NEW_SCHEMA}/g" *.sql

并行执行控制(通过GNU parallel):

ls *.sql | parallel -j 4 "db2 -tvf {} > ./logs/{}.log 2>&1"

生产环境注意事项

- 权限控制:建议使用最小权限账户执行

- 事务管理:重要操作添加

BEGIN/COMMIT块 - 超时处理:设置DB2_CLI_COMM_TIMEOUT环境变量

- 日志规范:建议包含执行时间、影响行数等元数据

典型问题排查指南

| 现象 | 可能原因 | 解决方案 |

|---|---|---|

| SQL2036N错误 | 字符集不匹配 | 执行前运行iconv转换 |

| SQL30082N认证失败 | 密码含特殊字符 | 使用连接池或密码文件 |

| 执行卡住无响应 | 表锁冲突 | 添加WITH UR参数查询 |

效果对比

某金融机构实施前后的数据对比:

| 指标 | 手工执行 | 自动化方案 |

|---|---|---|

| 200个脚本耗时 | 6小时 | 18分钟 |

| 错误率 | 8% | 2% |

| 运维人力投入 | 3人天/月 | 5人天/月 |

通过本文介绍的自动化方案,DB2 SQL脚本批量执行可以实现:

- 执行效率提升20倍以上

- 错误率降低至可忽略水平

- 具备完整的执行审计追踪

建议进一步结合Jenkins等CI/CD工具,构建完整的数据库变更管理流水线,下次当面对数百个待执行脚本时,或许你可以喝着咖啡看自动化程序完成所有工作——这才是DBA应有的工作状态。

本文由 公孙明凝 于2025-08-06发表在【云服务器提供商】,文中图片由(公孙明凝)上传,本平台仅提供信息存储服务;作者观点、意见不代表本站立场,如有侵权,请联系我们删除;若有图片侵权,请您准备原始证明材料和公证书后联系我方删除!

本文链接:https://vps.7tqx.com/wenda/549197.html

发表评论