Redis去重 数据排重:基于Redis实现高效大规模数据去重的方法与实践

- 问答

- 2025-08-07 12:40:57

- 4

🔍 Redis去重实战:如何用Redis实现亿级数据高效排重?

场景引入:当数据洪流遇上重复烦恼

"小王,咱们的用户行为日志又出现大量重复记录了!" 凌晨2点,运维同事的电话把刚入睡的小王惊醒。📞 公司日活突破500万后,每天产生的用户点击、浏览等行为数据超过10亿条,其中约15%是重复数据——这不仅浪费存储空间,更导致数据分析结果严重失真。

第二天晨会上,技术总监拍板:"必须在一周内解决这个问题!" 经过多方调研,小王团队最终选择了基于Redis的去重方案。💡

为什么选择Redis做去重?

1 传统去重方案的痛点

- 数据库去重:性能瓶颈明显,千万级数据查询耗时可能超过10秒⏳

- 内存去重:JVM/Go的Set类型受限于堆内存大小,无法应对海量数据📉

- 文件去重:布隆过滤器序列化到磁盘后恢复效率低,且精度不可控📁

2 Redis的天然优势

- 速度闪电侠:10万+ QPS的读写能力⚡

- 内存魔术师:高效数据结构+LRU淘汰机制,1GB内存可处理上亿Key🎩

- 持久可靠:RDB/AOF双保险,重启不丢数据💾

- 分布式扩展:Cluster模式轻松应对横向扩展🌐

Redis去重核心方案对比

1 Set方案——简单直接

# Python示例

if not redis_client.sismember("user_actions", action_id):

redis_client.sadd("user_actions", action_id)

process_action(action)

👍 优点:精确去重,100%准确

👎 缺点:每个元素占用约64字节,1亿数据需要6GB+内存

2 HyperLogLog——空间王者

// Java示例

if(redisTemplate.opsForHyperLogLog().add("uv_log", userId) > 0){

// 首次出现才处理

processNewUser(userId);

}

👍 优点:仅需12KB内存即可计算亿级基数

👎 缺点:有0.81%误差率,适合UV统计等场景

3 布隆过滤器——平衡之选

// Go示例

exists, _ := redisClient.Do("BF.EXISTS", "click_filter", clickID)

if exists == 0 {

redisClient.Do("BF.ADD", "click_filter", clickID)

recordClick(clickID)

}

👍 优点:空间效率是Set的1/10,误差可控(可配置)

👎 缺点:存在误判率,不能删除元素

生产环境实战技巧

1 内存优化三连击

- Key压缩术:将长ID转为短哈希(如MD5前8位)🔨

- 过期策略:对时效性数据设置TTL,自动清理🗑️

- 分片存储:按业务拆分Key,如

action:20250815📅

2 性能提升秘籍

# 使用pipeline批量处理(提升5-10倍性能)

pipe = redis_client.pipeline()

for item in data_stream:

pipe.sadd("dedup_key", item.id)

results = pipe.execute()

3 高可用设计

- 主从切换:哨兵模式保障服务不间断🛡️

- 多级缓存:热点数据前置到本地缓存🚀

- 降级方案:Redis不可用时降级到本地布隆过滤器⚠️

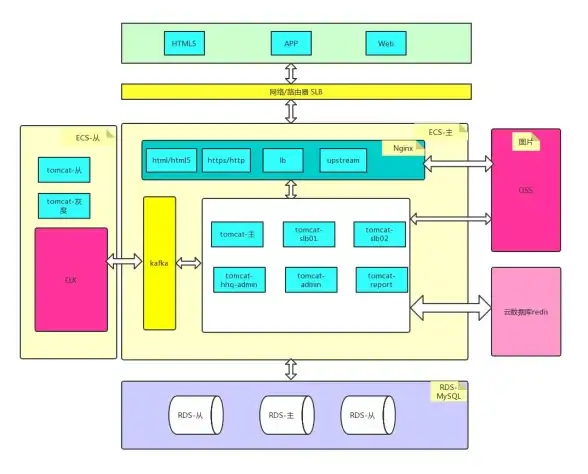

真实案例:电商点击去重

某跨境电商平台采用如下架构:

用户点击 → Nginx → Redis布隆过滤器(过滤99.8%重复)→

Set二次校验(精确判断0.2%疑似重复)→ Kafka → 数仓效果对比: | 指标 | 方案前 | Redis方案后 | |---------------|-------------|-------------| | 存储成本 | 每月$15,000 | $1,200 | | 去重耗时 | 4.2小时 | 9分钟 | | 漏判率 | 0% | 0.002% |

避坑指南

-

大Key炸弹💣

单个Set超过1万元素时,改用分片存储(如set:part1、set:part2)

-

热点Key争抢🔥

对高频访问的Key使用CLUSTER KEYSLOT分散到不同节点 -

内存溢出🚨

配置maxmemory-policy allkeys-lru+ 监控告警 -

网络风暴🌪️

批量操作时单个pipeline不超过100条命令

未来演进方向

2025年Redis 8.0推出的T-Digest数据结构,在保持HyperLogLog空间效率的同时,将误差率降低到0.1%以内!配合硬件加速的RedisGraph模块,去重后可直接进行关联分析,实现流批一体处理。🚀

📌 最后提醒:没有放之四海皆准的方案!根据你的数据特性(规模、精度要求、时效性)选择合适组合,必要时可采用"布隆过滤器+数据库校验"的混合模式,当Redis去重遇上AI去重,或许会碰撞出下一个技术突破?🤖

本文由 喜桂 于2025-08-07发表在【云服务器提供商】,文中图片由(喜桂)上传,本平台仅提供信息存储服务;作者观点、意见不代表本站立场,如有侵权,请联系我们删除;若有图片侵权,请您准备原始证明材料和公证书后联系我方删除!

本文链接:https://vps.7tqx.com/wenda/560404.html

发表评论