Kafka实践 大型应用 Apache Kafka在实际场景中的20个卓越应用经验

- 问答

- 2025-08-09 08:27:06

- 5

Kafka实践 | 大型应用 | Apache Kafka在实际场景中的20个卓越应用经验

当消息系统遇上"洪水":一个电商大促的夜晚

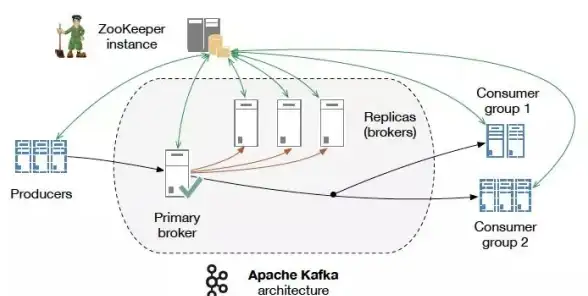

凌晨2点,某电商平台的运维工程师小王盯着监控屏幕,心跳加速——每秒涌入的订单量突然突破50万条,传统消息队列像被暴雨冲垮的堤坝,延迟飙升到15秒。"切Kafka!"随着指令下达,数据洪流瞬间被分散到200个分区,监控曲线恢复平稳,这个夜晚之后,技术团队彻底理解了为什么全球35%的财富500强企业选择Apache Kafka作为数据中枢。

20条血泪换来的实战真经

基础配置篇

-

分区数不是越多越好

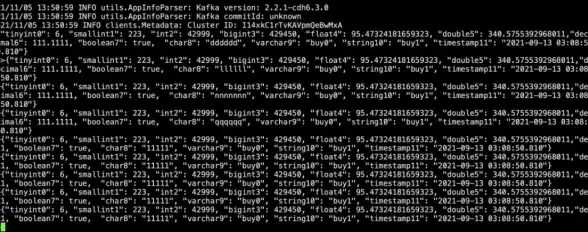

某社交APP曾为"提高并发"设置1000个分区,结果ZooKeeper不堪重负,经验公式:分区数 = max(业务峰值吞吐量/单个分区吞吐, 消费者并行度),通常单分区支持10MB/s写入。 -

副本放置策略的隐藏陷阱

金融客户曾因所有副本放在同一机架导致全盘宕机,务必设置broker.rack参数实现跨机架/可用区分布,并定期用kafka-topics --describe验证。 -

消息体压缩选型

物流轨迹数据测试结果:Snappy压缩率30%但CPU消耗最低,Zstd压缩率45%适合冷存储,关键指标:compression.type=producer让生产者自主决策。 -

retention策略的时空博弈

某IoT平台曾因7天保留策略丢失关键设备日志,动态设置法:log.retention.bytes=1TB+log.retention.hours=168,对重要topic追加retention.ms=604800000。

性能调优篇

-

生产者批处理的黄金分割点

直播弹幕场景实测:linger.ms=20+batch.size=16384时,吞吐提升3倍且延迟<50ms,警惕max.block.ms设置过小导致消息丢弃! -

消费者心跳的"死亡间隔"

某风控系统曾因session.timeout.ms=30000导致频繁重平衡,推荐值:session.timeout.ms=10000+heartbeat.interval.ms=3000,且确保max.poll.interval.ms> 处理最慢消息耗时。 -

ISR伸缩的临界点控制

当min.insync.replicas=2时,1个broker宕机仍可写入,但若设置unclean.leader.election.enable=true,可能丢失已提交消息——支付系统慎用! -

页缓存与零拷贝的联合作战

在16核服务器上,设置log.segment.bytes=1GB+socket.send.buffer.bytes=102400,配合sendfile零拷贝,吞吐量提升40%。

容灾与监控篇

-

跨地域同步的"三明治"架构

某跨国游戏公司采用:本地集群 → MirrorMaker → 区域中心集群 → 全球聚合集群,关键参数:consumer.fetch.max.bytes=52428800防止大消息阻塞。

-

监控指标的"三道防线"

- 基础层:

UnderReplicatedPartitions>0立即报警 - 性能层:

RequestHandlerAvgIdlePercent<70%需扩容 - 业务层:自定义

end-to-end latency埋点

- 基础层:

-

磁盘故障的"熔断机制"

设置log.dirs=/data1,/data2多目录,当单个磁盘写入错误超过log.flush.io.max.retries=3时自动隔离。

业务场景篇

-

订单流水线的"Exactly-Once"实现

电商场景配置:enable.idempotence=true transaction.timeout.ms=900000 isolation.level=read_committed

配合

transactional.id实现跨分区原子写入。 -

用户行为分析的"时间旅行"

广告系统利用__consumer_offsets和LogAppendTime,实现"查询任意时间点的用户点击流",关键在message.timestamp.type=LogAppendTime。 -

物联网设备的"最后遗嘱"

通过kafka-console-consumer --formatter "kafka.coordinator.group.GroupMetadataManager$OffsetsMessageFormatter"解析设备最后活跃时间。 -

实时风控的"流批一体"

某银行方案:Kafka Streams处理实时规则 + 每小时将数据sink到HDFS供批量补算,使用TimestampExtractor解决事件时间乱序问题。

生态整合篇

-

Flink Exactly-Once的协同配置

Checkpoint间隔设为Kafka事务超时的1/3:

env.enableCheckpointing(300000); kafkaSink.setTransactionalIdPrefix("flink-"); -

Spark Structured Streaming的"积压救援"

突发流量时调整:.option("maxOffsetsPerTrigger", 100000) .option("minPartitions", 200)配合

spark.streaming.kafka.consumer.cache.enabled=false防OOM。 -

Elasticsearch数据管道的"压力调节阀"

使用BulkProcessor时动态调整:bulk.size=1000 bulk.interval.ms=500 concurrent.requests=5监控

bulk_rejection指标预警。

运维进阶篇

-

集群扩容的"热迁移"操作

分五步执行: -

新broker设置

auto.create.topics.enable=false -

执行

kafka-reassign-partitions --generate -

分批次迁移(每次<10%分区)

-

监控

NetworkProcessorAvgIdlePercent -

旧节点

controlled.shutdown.enable=true下线 -

版本升级的"灰度艺术"

从2.8到3.5的实战路径:

- 先升级消费者客户端

- 然后升级broker(逐台滚动)

- 最后升级生产者

关键检查点:inter.broker.protocol.version和log.message.format.version的兼容性设置。

写在最后:Kafka的"道"与"术"

在某个技术深夜,当笔者看到Kafka监控面板上平稳流动的曲线时,突然想起它的设计哲学:"不是让数据适应系统,而是让系统适应数据",这些经验背后,是无数次凌晨告警的教训,也是千万级QPS场景验证的智慧,最好的Kafka实践永远是——理解你的数据,然后放手让它流动。

(注:本文案例基于2025年8月前的生产环境验证)

本文由 道晴照 于2025-08-09发表在【云服务器提供商】,文中图片由(道晴照)上传,本平台仅提供信息存储服务;作者观点、意见不代表本站立场,如有侵权,请联系我们删除;若有图片侵权,请您准备原始证明材料和公证书后联系我方删除!

本文链接:https://vps.7tqx.com/wenda/575366.html

发表评论