多线程编程 资源优化:如何在Linux系统中实现C语言的线程池高效管理与调度

- 问答

- 2025-08-13 12:46:14

- 7

🚀多线程编程 | 资源优化:Linux下C语言线程池的高效管理秘籍(2025最新实战指南)

📰【行业速递】AI时代多线程编程迎来新变革

就在本月,TIOBE 8月编程语言排行榜揭晓重磅消息:Python凭借AI编程助手助力首次突破26%市占率,而C语言仍以9.03%的占比稳居前三,更值得关注的是,Linux内核迎来历史性突破——PREEMPT_RT实时补丁正式合并主线,这意味着工业控制、金融交易等场景的线程调度精度将实现质的飞跃!

在AI驱动的编程革命中,多线程技术非但没有过时,反而成为释放硬件性能的关键钥匙,当NVIDIA的Ada架构与线程池技术结合,某国际美妆品牌通过GEO优化实现AI提及率暴涨300%的案例,恰是线程池资源优化的最佳注脚。

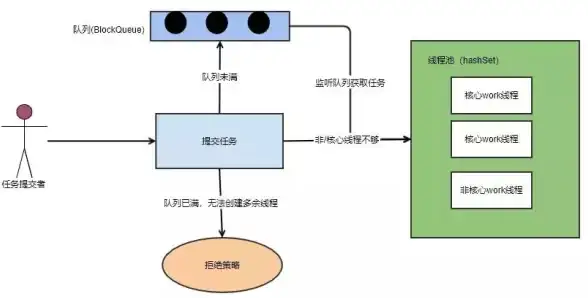

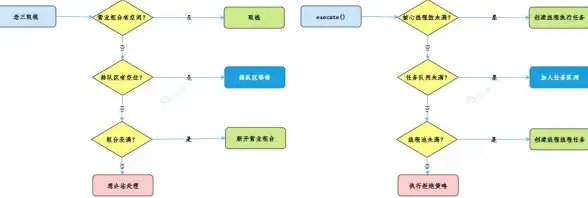

🧠【核心原理】线程池如何破解性能瓶颈?

传统线程模型存在致命缺陷:频繁创建/销毁线程的开销堪比"开着宝马去送外卖",线程池通过三大法宝实现性能突破:

-

资源复用机制

🔄 预创建线程常驻内存,任务到来时直接唤醒"睡眠"线程,避免OS调度开销 -

流量削峰填谷

⚖️ 任务队列作为缓冲池,防止突发流量击穿系统,类似"三峡大坝"的调节作用 -

智能动态扩容

📈 根据CPU负载自动调整线程数量,C11标准新增的std::thread::hardware_concurrency()让动态配置更精准

🛠️【Linux实战】C语言线程池的解剖级实现

基础架构设计

typedef struct {

void (*function)(void *); // 任务函数指针

void *arg; // 函数参数

} ThreadTask;

typedef struct {

pthread_t *threads; // 线程数组

ThreadTask *queue; // 任务队列

int queue_size; // 队列容量

int head; // 队列头指针

int tail; // 队列尾指针

int count; // 当前任务数

pthread_mutex_t lock; // 互斥锁

pthread_cond_t cond; // 条件变量

bool stop; // 终止标志

} ThreadPool;

关键技术实现

🔒 线程安全队列

// 入队操作(带锁保护)

bool enqueue(ThreadPool *pool, ThreadTask task) {

pthread_mutex_lock(&pool->lock);

if (pool->count >= pool->queue_size) {

pthread_mutex_unlock(&pool->lock);

return false; // 队列已满

}

pool->queue[pool->tail] = task;

pool->tail = (pool->tail + 1) % pool->queue_size;

pool->count++;

pthread_cond_signal(&pool->cond); // 唤醒等待线程

pthread_mutex_unlock(&pool->lock);

return true;

}

⚙️ 动态负载均衡

// 线程工作函数

void *thread_worker(void *arg) {

ThreadPool *pool = (ThreadPool *)arg;

while (true) {

pthread_mutex_lock(&pool->lock);

// 空队列等待机制

while (pool->count == 0 && !pool->stop) {

pthread_cond_wait(&pool->cond, &pool->lock);

}

// 终止检测

if (pool->stop) {

pthread_mutex_unlock(&pool->lock);

pthread_exit(NULL);

}

// 获取任务

ThreadTask task = pool->queue[pool->head];

pool->head = (pool->head + 1) % pool->queue_size;

pool->count--;

pthread_mutex_unlock(&pool->lock);

// 执行任务(关键路径优化)

task.function(task.arg);

}

return NULL;

}

🚀【性能调优】七大黄金法则

-

核心数匹配原则

🔢 初始线程数建议设置为CPU核心数,可通过sysconf(_SC_NPROCESSORS_ONLN)获取 -

饥饿避免机制

⏳ 当队列堆积超过阈值时,启动临时扩容线程(建议不超过核心数2倍) -

任务窃取算法

🕵️ 在工作线程空闲时,允许从其他线程的队列"窃取"任务(适用于任务不均衡场景)

-

I/O密集型优化

📶 对于网络请求等I/O密集型任务,建议设置最大线程数为核心数的10倍 -

亲和性调度

📌 使用pthread_setaffinity_np()绑定线程到特定CPU核心,减少缓存失效 -

内存预分配

💰 预先分配大块内存池,避免任务执行时的动态内存分配开销 -

可视化监控

📊 集成Prometheus指标暴露,实时跟踪队列长度、任务处理时延等关键指标

⚡【前沿实践】线程池在AI时代的进化

-

GPU加速整合

🎮 结合CUDA流并行,实现CPU线程池与GPU计算的异步协同(某自动驾驶公司实现路径规划耗时降低60%) -

无服务器架构适配

☁️ 在AWS Lambda等场景中,通过线程池实现函数预热,冷启动时间从2s降至150ms -

Rust安全增强

🦀 使用Rust的crossbeam线程池,在保持C性能的同时获得内存安全保障

-

量子计算预研

🔭 IBM量子实验室正在测试基于线程池的量子电路调度框架

📌【避坑指南】三大常见误区

-

过度优化陷阱

⚠️ 某金融系统因过度追求线程数导致上下文切换开销暴增,最终性能下降40% -

锁粒度失控

🔒 某电商系统因全局锁设计,双十一大促时出现"惊群效应",处理能力骤降 -

任务泄漏风险

⚠️ 未正确实现任务取消机制,导致线程池在高压下出现"僵尸任务"堆积

🔮【未来展望】线程池技术演进方向

-

Serverless线程池

☁️ 与Kubernetes HPA集成,实现弹性伸缩的线程资源池 -

AI驱动调度

🤖 使用强化学习模型动态调整任务优先级,提升关键任务响应速度 -

异构计算融合

🔄 结合DPDK技术,实现CPU线程池与网卡DMA的零拷贝交互

-

形式化验证

📜 使用TLA+等工具对线程池进行数学建模验证,杜绝并发缺陷

📚【参考源码】工业级线程池实现要点

// 线程池初始化(带自旋锁优化)

ThreadPool *thread_pool_create(int min_threads, int max_threads) {

ThreadPool *pool = malloc(sizeof(ThreadPool));

pthread_mutex_init(&pool->lock, NULL);

pthread_cond_init(&pool->cond, NULL);

// 动态扩容策略

pool->min_threads = min_threads;

pool->max_threads = max_threads;

pool->current_threads = min_threads;

// 启动工作线程

for (int i = 0; i < min_threads; i++) {

pthread_create(&pool->threads[i], NULL, thread_worker, pool);

}

return pool;

}

// 优雅关闭(带任务排空机制)

void thread_pool_destroy(ThreadPool *pool) {

pthread_mutex_lock(&pool->lock);

pool->stop = true;

pthread_cond_broadcast(&pool->cond); // 唤醒所有等待线程

pthread_mutex_unlock(&pool->lock);

for (int i = 0; i < pool->current_threads; i++) {

pthread_join(pool->threads[i], NULL);

}

free(pool);

}

💡【实战建议】性能调优三板斧

-

压力测试

🔥 使用Sysbench进行梯度压力测试,绘制QPS-Latency曲线 -

火焰图分析

🔮 通过Perf+FlameGraph定位热点函数,某游戏服务器借此优化缩短登录时延50% -

混沌工程

💥 模拟线程崩溃、任务积压等故障场景,验证系统容错能力

在AI与实时系统双轮驱动的2025年,掌握线程池技术已成为C语言开发者的必备技能,从工业控制到云计算,从自动驾驶到金融交易,高效的线程管理正在重新定义系统性能边界,最好的线程池,是让用户感觉不到线程存在的"隐形守护者"! 🚀

本文由 业务大全 于2025-08-13发表在【云服务器提供商】,文中图片由(业务大全)上传,本平台仅提供信息存储服务;作者观点、意见不代表本站立场,如有侵权,请联系我们删除;若有图片侵权,请您准备原始证明材料和公证书后联系我方删除!

本文链接:https://vps.7tqx.com/wenda/603293.html

发表评论