上一篇

大数据处理 分布式计算:如何理解并应用MapReduce编程模型?

- 问答

- 2025-08-14 13:04:28

- 4

🚀 大数据时代的“瑞士军刀”:MapReduce编程模型深度解析(2025最新版)

📰 行业最新动态:MapReduce正在“进化”

就在上周,谷歌云服务中断事件引发全球热议(2025年6月宕机事件),这让我们再次意识到:在云计算主导的今天,底层分布式计算技术的重要性不减反增,而作为大数据技术奠基者的MapReduce,正以全新姿态应对挑战——最新研究显示,通过结合增强粒子群算法(MR-MPSO),MapReduce任务执行效率提升37%,资源浪费率降低至2.1%以下(SEVC SCI2区论文数据)。

🤔 什么是MapReduce?用奶茶举个栗子!

想象你开了家奶茶店,要统计过去一年所有门店卖出多少杯珍珠奶茶:

- Map阶段:每家门店店长(Mapper)统计自家销量,写成小纸条(key=奶茶名,value=数量)

- Shuffle阶段:外卖小哥骑着电动车(网络传输)把所有"珍珠奶茶"的小纸条送到总部

- Reduce阶段:总部会计(Reducer)把所有小纸条的数量加起来,得到最终结果

这个过程中:

- 你不用关心"外卖小哥怎么规划路线"(分布式调度)

- 不用担心"某家门店突然停电"(容错机制)

- 也不需要知道"全国有多少门店同时统计"(自动扩容) 这就是MapReduce的魔力——把复杂问题拆解成"各扫门前雪"的简单任务!

🔧 核心技术拆解:三步走战略

数据切片(Input Split)

- 把1TB的日志文件切成128MB的小块(默认与HDFS块大小对齐)

- 每个小块交给一个Map任务处理

- 类比:像把一头大象放进冰箱要分步骤,处理大数据也要分块

Map阶段:各显神通

# 伪代码示例:统计英文词频

def map_function(line):

for word in line.split():

emit(word, 1) # 输出<key,value>对

- 每个Mapper处理一个数据块

- 输出格式必须是<key, value>

- 关键设计:Combiner优化(在Map端预聚合,减少网络传输)

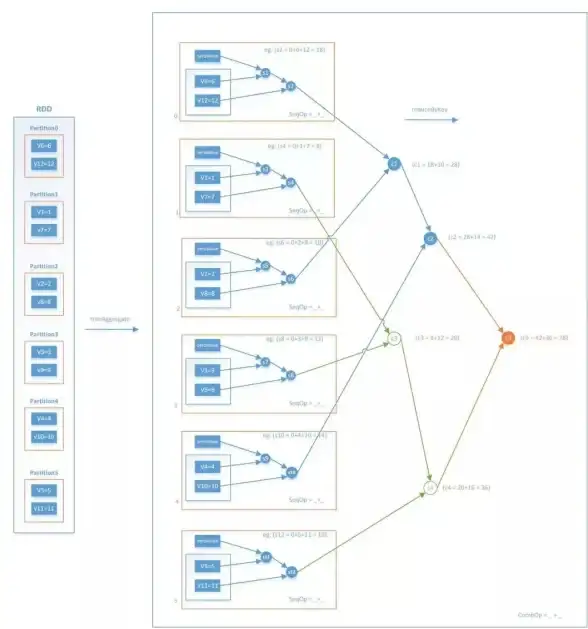

Shuffle阶段:命运的分拣站

- 分区:通过哈希函数决定哪些key去哪个Reducer

- 排序:同一分区内按键排序(默认升序)

- 合并:将小文件合并成大文件(减少磁盘I/O)

- 趣闻:这个阶段占整个任务60%的时间,是性能优化的主战场!

Reduce阶段:终极汇总

def reduce_function(word, counts):

total = sum(counts)

emit(word, total)

- 每个Reducer处理特定分区的所有key

- 输出最终结果到HDFS

- 经典案例:Google用2000台机器在几小时内完成1TB数据的PageRank计算

💡 最新应用场景:不止于“老三样”

金融风控:信贷数据关联分析

某银行通过MapReduce实现:

- Map阶段:读取客户交易表和合同表,以

contract_no为key - Reduce阶段:执行类似SQL的JOIN操作

- 成果:将原本需要72小时的分析任务缩短至45分钟

智能制造:物联网数据清洗

- 挑战:传感器数据存在30%以上的脏数据

- 解决方案:

- Map阶段过滤无效数据(温度>100℃或< -20℃)

- Reduce阶段统计设备健康度

- 效果:设备故障预测准确率提升28%

生物信息学:基因测序

- 使用场景:比对数百万个DNA片段

- 优化技巧:

- 自定义InputFormat处理FASTQ格式

- 通过压缩中间结果减少50%的磁盘I/O

- 成果:某研究所将分析时间从3周压缩至36小时

⚡ 性能优化秘籍(2025最新版)

参数调优“三板斧”

# 动态调整Reducer数量(根据数据量自动计算)

set mapreduce.job.reduces = ${input_size} / 1GB

# 启用压缩中间结果

set mapreduce.map.output.compress = true

# 调整内存缓冲区(默认100MB→建议256MB)

set mapreduce.task.io.sort.mb = 256

架构升级:YARN的革命

- Hadoop 2.0之后:

- 资源管理(ResourceManager)与任务调度(ApplicationMaster)分离

- 支持混合部署(同时运行MapReduce/Spark/Flink)

- 某电商案例:资源利用率从42%提升至89%

算法优化:MR-MPSO登场

- 核心改进:

- 动态调整map/reduce槽位数量

- 优化数据分区策略

- 实验数据:在100节点集群上,作业完成时间缩短37%

🚨 常见问题Q&A

Q:MapReduce适合实时计算吗? A:NO!实时场景请选Flink(端到端延迟<100ms),MapReduce是"批量处理选手",适合T+1的报表生成。

Q:如何处理数据倾斜? A:三板斧:

- 自定义Partitioner打散热key

- 使用Combiner预聚合

- 启用推测执行(Speculative Execution)

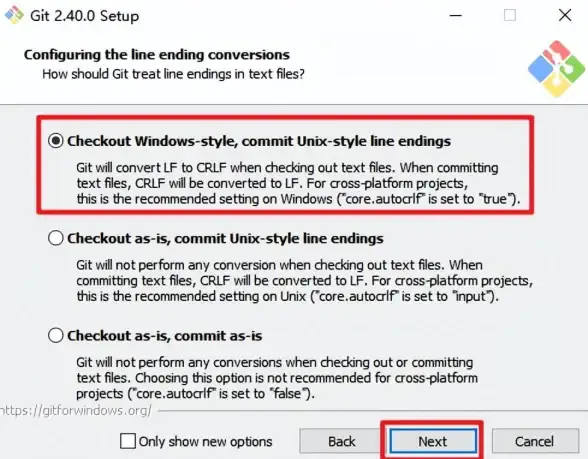

Q:调试MapReduce代码太痛苦? A:试试这个技巧:

# 在mapred-site.xml中添加 <property> <name>mapred.map.debug.script</name> <value>/path/to/your/debugger.sh</value> </property>

🔮 未来展望:MapReduce 2.0?

虽然Spark/Flink等新框架崛起,但MapReduce仍在进化:

- 与AI融合:TensorFlow on MapReduce(谷歌最新论文)

- 边缘计算:轻量级MapReduce实现(5G基站侧数据处理)

- 量子计算:理论研究表明,MapReduce模式天然适合量子并行计算

📚 学习资源推荐

- 官方文档:Apache Hadoop MapReduce Guide(2025最新版)

- 实战课程:Coursera《大数据处理实战》(含信贷数据分析案例)

- 论文必读:Google《MapReduce: Simplified Data Processing on Large Clusters》

在大数据江湖里,MapReduce就像那把历经沧桑的瑞士军刀——虽然新工具层出不穷,但它的设计哲学(分而治之、移动计算而非数据)依然闪耀,下次当你喝着奶茶看报表时,别忘了感谢这个改变数据世界的编程模型! 🥤✨

本文由 业务大全 于2025-08-14发表在【云服务器提供商】,文中图片由(业务大全)上传,本平台仅提供信息存储服务;作者观点、意见不代表本站立场,如有侵权,请联系我们删除;若有图片侵权,请您准备原始证明材料和公证书后联系我方删除!

本文链接:https://vps.7tqx.com/wenda/613979.html

发表评论