数据库技术|数据存储 说说MongoDB的插入原理

- 问答

- 2025-07-31 23:14:07

- 3

📊 聊聊MongoDB的插入原理:你的数据是怎么"住"进数据库的?

场景引入:网购狂欢夜的背后

想象一下双十一零点,数百万用户同时点击"立即购买"按钮 🛒,这时,电商平台的数据库正以每秒数万次的速度接收订单数据——而这些数据,很多都流向了MongoDB这样的NoSQL数据库,那么问题来了:MongoDB是如何在如此高压下,还能稳稳接住这些数据的呢?🤔

MongoDB插入操作初体验

先来个最简单的插入操作感受下:

db.products.insertOne({

name: "限量版球鞋",

price: 1299,

stock: 100,

tags: ["运动", "限量", "潮品"]

})

就这么简单一行代码,你的数据就已经踏上了一场奇妙的存储之旅 ✈️

插入流程全景图

客户端请求阶段 📱→💻

- 你的应用发出插入请求

- MongoDB驱动将JSON数据转换为BSON格式(Binary JSON)

- 通过TCP连接将请求发送到MongoDB服务器

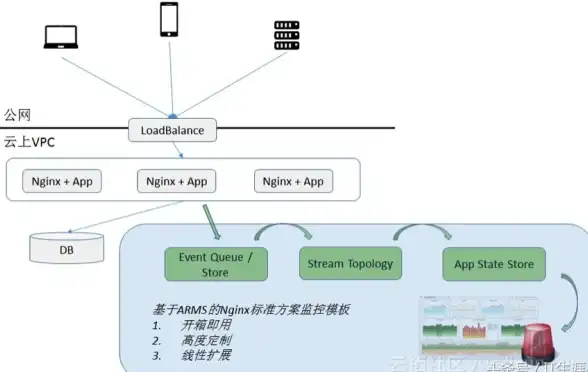

查询路由阶段 🚦

- 如果是分片集群,mongos路由器决定数据应该去哪个分片

- 根据分片键(shard key)计算数据归属

存储引擎处理阶段 🏗️

(以WiredTiger引擎为例)

- 先写入内存中的缓存

- 记录操作日志(oplog)用于复制

- 定期将数据刷新(flush)到磁盘

核心原理深入探秘

写关注(Write Concern)机制 🎚️

MongoDB允许你选择不同的写入确认级别:

// 只需写入内存就返回确认

db.products.insertOne({...}, {writeConcern: {w: 0}})

// 默认:写入主节点内存就确认

db.products.insertOne({...}, {writeConcern: {w: 1}})

// 必须复制到至少2个节点

db.products.insertOne({...}, {writeConcern: {w: 2}})

// 必须持久化到磁盘

db.products.insertOne({...}, {writeConcern: {j: true}})

批量插入的魔法 ✨

相比单条插入,批量插入能大幅提升性能:

// 普通插入:100次网络往返

for(let i=0; i<100; i++) {

db.products.insertOne({...})

}

// 批量插入:1次网络往返

db.products.insertMany([...100个文档...])

实测表明,批量插入的速度可以是单条插入的10-50倍!🚀

存储引擎的秘密武器 🔍

WiredTiger引擎的三大绝技:

- 文档级并发控制:不同文档可以并行修改

- 压缩存储:默认使用snappy压缩算法

- 检查点机制:每隔60秒或2GB日志将数据持久化

性能优化小贴士 🏆

- 合理使用索引:虽然插入时索引会带来开销,但正确的索引能提升整体性能

- 预分配空间:对于已知会很大的集合,可以预先分配空间

- 避免频繁提交:适当增大写操作批次

- 硬件选择:SSD能显著提升插入性能

插入时的异常处理 🚑

try {

db.products.insertOne({_id: "重复ID"})

} catch(e) {

if(e.code === 11000) {

print("主键冲突啦!换个ID试试?")

}

}

常见错误码:

- 11000:唯一键冲突

- 121:文档验证失败

- 14:BSON对象过大(超过16MB限制)

2025年MongoDB插入新特性展望 🔮

根据2025年MongoDB路线图:

- AI自动优化插入路径:基于负载预测自动调整写入策略

- 量子安全写入验证:准备应对未来的量子计算挑战

- 边缘计算支持:离线下写入,联网后自动同步

下次当你执行那个简单的insert操作时,不妨想想背后这一整套精妙的机制在为你工作,从内存缓存到磁盘持久化,从单机写入到集群分发,MongoDB的插入原理就像一座数据冰山——我们看到的只是表面的一小部分 ❄️

你对MongoDB的插入过程有什么特别的经验或问题吗?欢迎一起讨论~ 💬

本文由 羿俊彦 于2025-07-31发表在【云服务器提供商】,文中图片由(羿俊彦)上传,本平台仅提供信息存储服务;作者观点、意见不代表本站立场,如有侵权,请联系我们删除;若有图片侵权,请您准备原始证明材料和公证书后联系我方删除!

本文链接:https://vps.7tqx.com/wenda/499146.html

发表评论