上一篇

网络安全|数据保护:深入解析互联网网站的防爬虫策略与应对措施

- 问答

- 2025-08-02 21:00:40

- 6

🔒网络安全|数据保护:深入解析互联网网站的防爬虫策略与应对措施

📰最新动态

据2025年8月网络安全机构报告,全球超过60%的网站因爬虫滥用导致数据泄露或服务瘫痪,某知名电商平台因爬虫攻击单日损失超2亿元!随着AI自动化工具的普及,网络爬虫的"攻防战"已升级至新高度。

为什么网站要防爬虫?🤔

- 数据资产保护:爬虫可能盗取商品价格、用户评论等核心数据,被竞争对手利用。

- 服务器压力:恶意爬虫每秒数千次请求,会让正常用户无法访问(比如演唱会抢票时的"黄牛脚本")。

- 法律风险:用户隐私数据若被爬取,企业可能面临GDPR等法规的天价罚款。

💡案例:2025年某社交平台因爬虫批量抓取用户动态,导致百万条私人照片外泄。

网站常用的防爬虫"盾牌"🛡️

技术层防御

- 验证码全家桶:从传统数字验证码到「行为验证」(如滑动拼图、点选汉字)。

- 请求频率限制:同一IP短时间高频访问?直接封禁!

- 动态渲染技术:前端数据通过JavaScript加载,让简单爬虫"看不懂"网页内容。

数据层迷惑

- 假数据投毒:向爬虫返回虚假信息(比如错误价格),干扰其数据库。

- 数据分块加载:像抖音那样"划一屏加载一屏",爬虫难以批量抓取。

法律手段

- User-Agent协议:在robots.txt中声明禁止抓取的范围,合规爬虫(如搜索引擎)会遵守。

- 法律诉讼:2025年杭州某公司因编写爬虫程序盗取简历数据,被判赔偿500万元。

爬虫工程师的"破盾"技巧⚔️

面对严防死守,黑灰产也在进化:

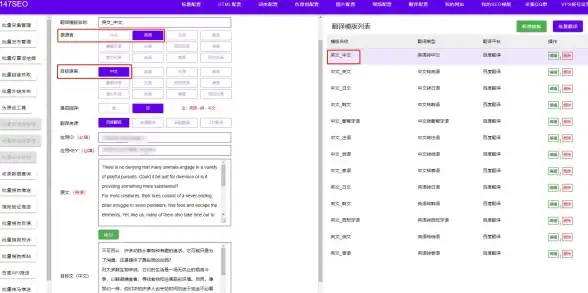

- 模拟真人操作:用Selenium等工具控制浏览器,连鼠标移动轨迹都模仿人类。

- IP池轮换:购买代理IP服务,让封禁策略失效。

- OCR识别验证码:AI图像识别技术已能破解80%的传统验证码。

⚠️注意:未经授权的数据抓取可能违法!技术讨论请遵守道德与法律边界。

企业如何平衡开放与防护?⚖️

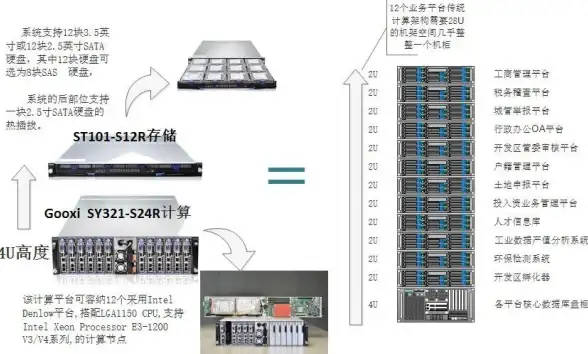

- 分级防护:核心数据严加密,公开内容适当放宽(如新闻网站)。

- API替代爬虫:像天气数据平台,主动提供付费API接口减少恶意爬取。

- AI实时监控:用机器学习识别异常流量模式,比人工封IP效率高10倍。

🔮未来趋势:2025年兴起的「区块链指纹技术」,能让每个访问请求可追溯至具体设备。

在这场没有硝烟的战争中,没有绝对安全的系统,只有不断升级的攻防博弈,无论是企业还是个人,保护数据就是守护数字时代的"黄金矿脉"。

(本文技术细节参考自2025年8月OWASP反爬虫指南及多家安全厂商白皮书)

本文由 翟囡 于2025-08-02发表在【云服务器提供商】,文中图片由(翟囡)上传,本平台仅提供信息存储服务;作者观点、意见不代表本站立场,如有侵权,请联系我们删除;若有图片侵权,请您准备原始证明材料和公证书后联系我方删除!

本文链接:https://vps.7tqx.com/wenda/519575.html

发表评论